Maximización de la verosimilitud, Parte 1

Antes, elegimos la mean de la muestra como estimación del parámetro del modelo poblacional mu. Pero ¿cómo sabemos que la media muestral es el mejor estimador? Esto es delicado, así que hagámoslo en dos partes.

En la Parte 1, usarás un enfoque computacional para calcular la log-verosimilitud de una estimación dada. Luego, en la Parte 2, veremos que, al calcular la log-verosimilitud para muchos posibles valores de la estimación, uno de ellos dará como resultado la verosimilitud máxima.

Este ejercicio forma parte del curso

Introducción al modelado lineal en Python

Instrucciones del ejercicio

- Calcula

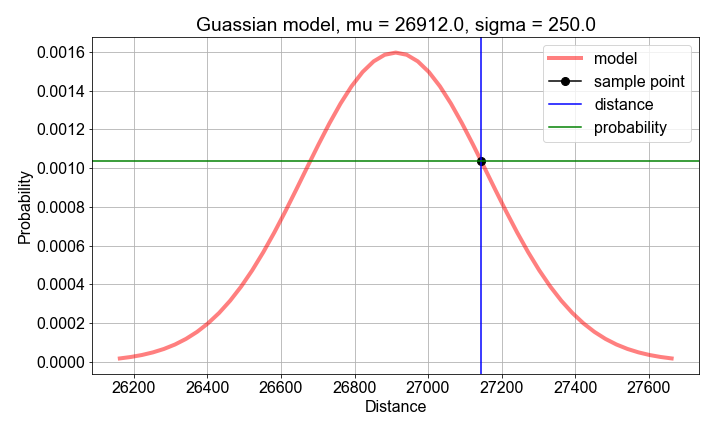

mean()ystd()desample_distances(precargado) como los valores estimados de los parámetros del modelo de probabilidad. - Calcula la probabilidad, para cada

distance, usandogaussian_model()construida a partir desample_meanysample_stdev. - Calcula la

loglikelihoodcomo lasum()dellog()de las probabilidadesprobs.

Ejercicio interactivo práctico

Prueba este ejercicio y completa el código de muestra.

# Compute sample mean and stdev, for use as model parameter value guesses

mu_guess = np.____(sample_distances)

sigma_guess = np.____(sample_distances)

# For each sample distance, compute the probability modeled by the parameter guesses

probs = np.zeros(len(sample_distances))

for n, distance in enumerate(sample_distances):

probs[n] = gaussian_model(____, mu=____, sigma=____)

# Compute and print the log-likelihood as the sum() of the log() of the probabilities

loglikelihood = np.____(np.____(probs))

print('For guesses mu={:0.2f} and sigma={:0.2f}, the loglikelihood={:0.2f}'.format(mu_guess, sigma_guess, ____))