Calcul des Q-valeurs

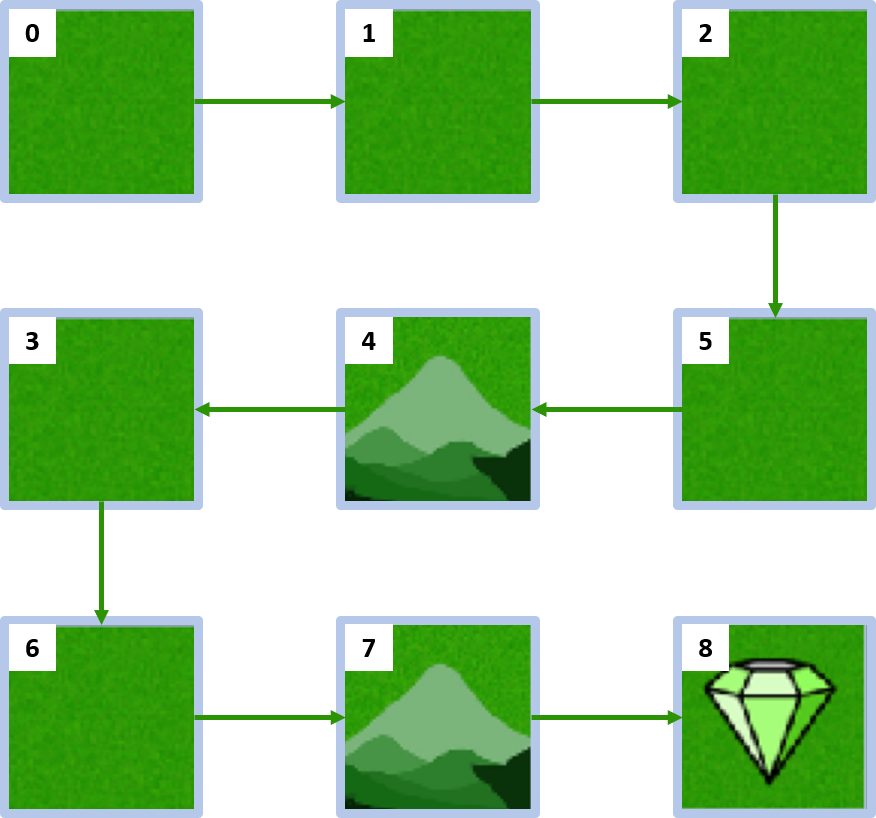

Votre objectif est de calculer les valeurs d’action, également appelées Q-valeurs, pour chaque paire état–action dans l’environnement personnalisé MyGridWorld en suivant la politique ci-dessous. En RL, les Q-valeurs sont essentielles car elles représentent l’utilité attendue de l’exécution d’une action donnée dans un état donné, suivie du respect de la politique.

L’environnement a été importé sous le nom env ainsi que la fonction compute_state_value() et les variables nécessaires (terminal_state, num_states, num_actions, policy, gamma).

Cet exercice fait partie du cours

Reinforcement Learning avec Gymnasium en Python

Instructions

- Complétez la fonction

compute_q_value()pour calculer la valeur d’action pour unstateet uneactiondonnés. - Créez un dictionnaire

Qoù chaque clé représente une paire état–action, et la valeur correspondante est la Q-valeur de cette paire.

Exercice interactif pratique

Essayez cet exercice en complétant cet exemple de code.

# Complete the function to compute the action-value for a state-action pair

def compute_q_value(state, action):

if state == terminal_state:

return None

probability, next_state, reward, done = ____

return ____

# Compute Q-values for each state-action pair

Q = {(____, ____): _____ for ____ in range(____) for ____ in range(____)}

print(Q)