Preprocesamiento de imágenes

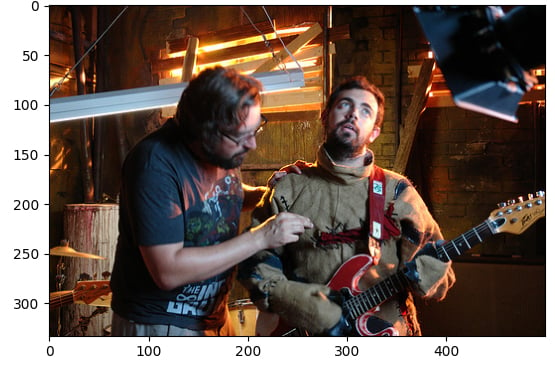

En este ejercicio, utilizarás el conjunto de datos flickr, que contiene 30 000 imágenes y sus correspondientes pies de foto, para realizar operaciones de preprocesamiento de imágenes. Este preprocesamiento es necesario para que los datos de la imagen sean adecuados para la inferencia con tareas del modelo Hugging Face, como la generación de texto a partir de imágenes. En este caso, generarás un pie de foto para esta imagen:

El conjunto de datos (dataset) se ha cargado con la siguiente estructura:

Dataset({

features: ['image', 'caption', 'sentids', 'split', 'img_id', 'filename'],

num_rows: 10

})

Se ha cargado el modelo de subtitulado de imágenes (model).

Este ejercicio forma parte del curso

Modelos multimodales con Hugging Face

Instrucciones del ejercicio

- Carga la imagen desde el elemento en el índice

5del conjunto de datos. - Carga el procesador de imágenes (

BlipProcessor) del modelo preentrenado:Salesforce/blip-image-captioning-base. - Ejecuta el procesador en

image, asegurándote de especificar que se requieren tensores PyTorch (pt). - Utiliza el método «

.generate()» para crear un título utilizando el «model».

Ejercicio interactivo práctico

Prueba este ejercicio y completa el código de muestra.

# Load the image from index 5 of the dataset

image = dataset[5]["____"]

# Load the image processor of the pretrained model

processor = ____.____("Salesforce/blip-image-captioning-base")

# Preprocess the image

inputs = ____(images=____, return_tensors="pt")

# Generate a caption using the model

output = ____(**inputs)

print(f'Generated caption: {processor.decode(output[0])}')

print(f'Original caption: {dataset[5]["caption"][0]}')