Die Dense-Layer-Operation verwenden

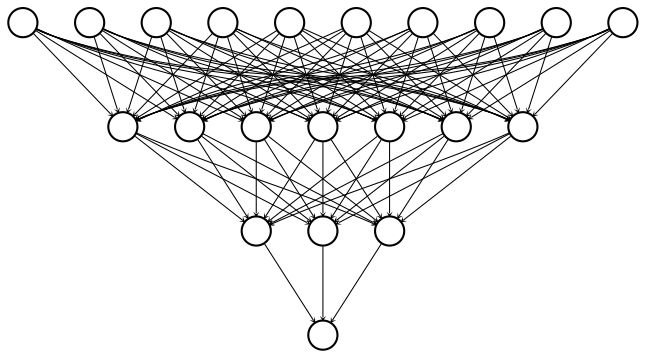

Wir haben nun gesehen, wie man Dense-Layer in tensorflow mithilfe von Linearalgebra definiert. In dieser Übung überspringen wir die Linearalgebra und lassen keras die Details erledigen. So können wir das unten gezeigte Netzwerk mit 2 versteckten Schichten und 10 Merkmalen mit weniger Code konstruieren, als wir für das Netzwerk mit 1 versteckten Schicht und 3 Merkmalen brauchten.

Um dieses Netzwerk zu bauen, müssen wir drei Dense-Layer definieren. Jeder nimmt die vorherige Schicht als Eingabe, multipliziert sie mit Gewichten und wendet eine Aktivierungsfunktion an. Beachte: Die Eingabedaten sind definiert und als 100×10-Tensor verfügbar: borrower_features. Außerdem ist das Modul keras.layers verfügbar.

Diese Übung ist Teil des Kurses

Einführung in TensorFlow mit Python

Anleitung zur Übung

- Setze

dense1auf einen Dense-Layer mit 7 Ausgabeknoten und einer Sigmoid-Aktivierungsfunktion. - Definiere

dense2als Dense-Layer mit 3 Ausgabeknoten und einer Sigmoid-Aktivierungsfunktion. - Definiere

predictionsals Dense-Layer mit 1 Ausgabeknoten und einer Sigmoid-Aktivierungsfunktion. - Gib die Formen von

dense1,dense2undpredictionsin dieser Reihenfolge mit der Methode.shapeaus. Warum haben diese Tensoren jeweils 100 Zeilen?

Interaktive Übung

Vervollständige den Beispielcode, um diese Übung erfolgreich abzuschließen.

# Define the first dense layer

dense1 = keras.layers.Dense(____, activation='____')(borrower_features)

# Define a dense layer with 3 output nodes

dense2 = ____

# Define a dense layer with 1 output node

predictions = ____

# Print the shapes of dense1, dense2, and predictions

print('\n shape of dense1: ', dense1.shape)

print('\n shape of dense2: ', ____.shape)

print('\n shape of predictions: ', ____.shape)