Una ronda de backpropagation

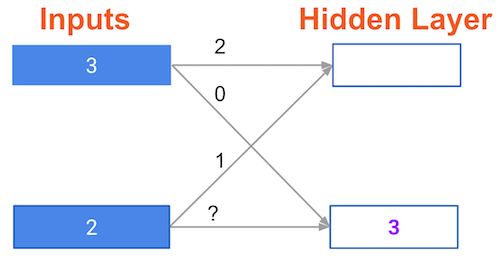

En la red que se muestra abajo, hemos hecho propagación hacia adelante, y los valores de los nodos calculados como parte de esa propagación aparecen en blanco. Los pesos se muestran en negro. Las capas después del signo de interrogación muestran las pendientes calculadas como parte del backpropagation, en lugar de los valores de forward-prop. Esos valores de pendiente se muestran en morado.

Esta red vuelve a usar la función de activación ReLU, así que la pendiente de la función de activación es 1 para cualquier nodo que reciba un valor positivo como entrada. Supón que el nodo que estamos examinando tenía un valor positivo (por lo tanto, la pendiente de la función de activación es 1).

¿Cuál es la pendiente necesaria para actualizar el peso con el signo de interrogación?

Este ejercicio forma parte del curso

Introducción al Deep Learning en Python

Ejercicio interactivo práctico

Pon en práctica la teoría con uno de nuestros ejercicios interactivos

Empezar ejercicio

Empezar ejercicio