Pré-processamento de imagens

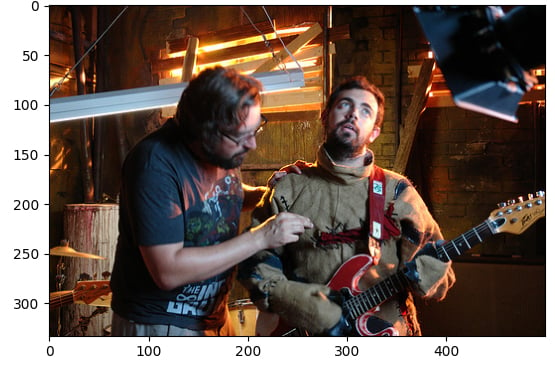

Neste exercício, você vai usar o conjunto de dados do Flickr, que tem 30.000 imagens e legendas associadas, para fazer operações de pré-processamento nas imagens. Esse pré-processamento é necessário para tornar os dados da imagem adequados para inferência com tarefas do modelo Hugging Face, como geração de texto a partir de imagens. Nesse caso, você vai criar uma legenda de texto para essa imagem:

O conjunto de dados (dataset) foi carregado com a seguinte estrutura:

Dataset({

features: ['image', 'caption', 'sentids', 'split', 'img_id', 'filename'],

num_rows: 10

})

O modelo de legenda de imagem (model) foi carregado.

Este exercício faz parte do curso

Modelos multimodais com Hugging Face

Instruções do exercício

- Carregue a imagem do elemento no índice

5do conjunto de dados. - Carregue o processador de imagens (

BlipProcessor) do modelo pré-treinado:Salesforce/blip-image-captioning-base. - Execute o processador em

image, certificando-se de especificar que os tensores PyTorch (pt) são necessários. - Use o método “

.generate()” para criar uma legenda usando o “model”.

Exercício interativo prático

Experimente este exercício completando este código de exemplo.

# Load the image from index 5 of the dataset

image = dataset[5]["____"]

# Load the image processor of the pretrained model

processor = ____.____("Salesforce/blip-image-captioning-base")

# Preprocess the image

inputs = ____(images=____, return_tensors="pt")

# Generate a caption using the model

output = ____(**inputs)

print(f'Generated caption: {processor.decode(output[0])}')

print(f'Original caption: {dataset[5]["caption"][0]}')