Eine Runde Rückwärtsausbreitung

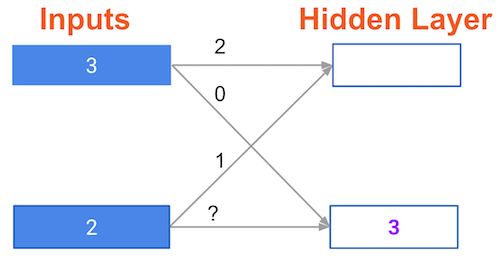

Im Netzwerk unten haben wir eine Vorwärtsausbreitung gemacht und die im Rahmen der Vorwärtsausbreitung berechneten Knotenwerte sind weiß dargestellt. Die Gewichte sind schwarz dargestellt. Die Ebenen nach dem Fragezeichen zeigen die Steigungen, die als Teil der Rückwärtspropagierung berechnet wurden, nicht die Vorwärtspropagierungswerte. Diese Neigungswerte sind in Lila dargestellt.

Dieses Netzwerk nutzt wieder die ReLU-Aktivierungsfunktion, sodass die Steigung der Aktivierungsfunktion für jeden Knoten, der einen positiven Wert als Eingabe bekommt, 1 ist. Angenommen, der untersuchte Knoten hatte einen positiven Wert (also ist die Steigung der Aktivierungsfunktion 1).

Wie stark muss die Steigung sein, um das Gewicht mit dem Fragezeichen zu aktualisieren?

Diese Übung ist Teil des Kurses

Einführung in Deep Learning mit Python

Interaktive Übung

In dieser interaktiven Übung kannst du die Theorie in die Praxis umsetzen.

Übung starten

Übung starten