Schauspieler Kritische Verlustberechnungen

Als letzten Schritt, bevor du deinen Agenten mit A2C trainieren kannst, schreibe eine calculate_losses() Funktion, die die Verluste für beide Netze zurückgibt.

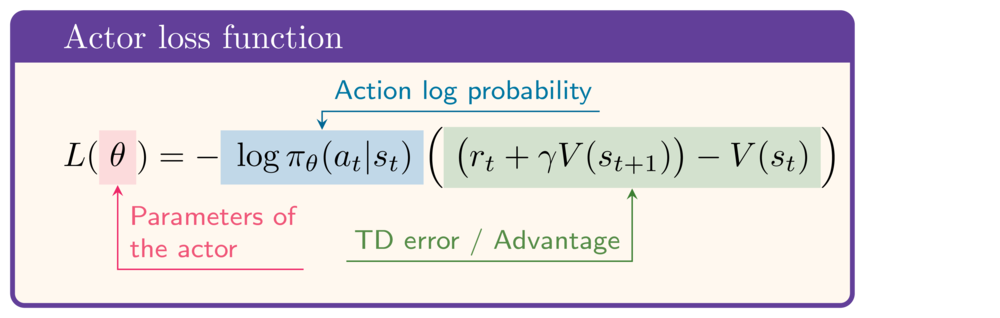

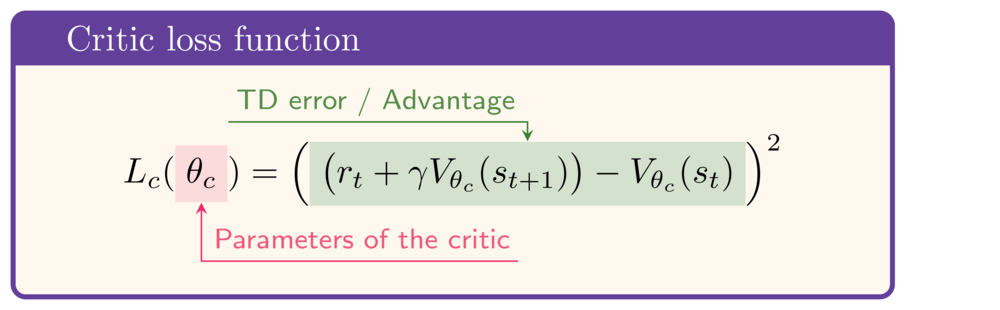

Zur Veranschaulichung sind dies die Ausdrücke für die Verlustfunktionen der Akteure und Kritiker:

Diese Übung ist Teil des Kurses

Deep Reinforcement Learning in Python

Anleitung zur Übung

- Berechne das TD Ziel.

- Berechne den Verlust für das Actor-Netzwerk.

- Berechne den Verlust für das kritische Netzwerk.

Interaktive Übung

Vervollständige den Beispielcode, um diese Übung erfolgreich abzuschließen.

def calculate_losses(critic_network, action_log_prob,

reward, state, next_state, done):

value = critic_network(state)

next_value = critic_network(next_state)

# Calculate the TD target

td_target = (____ + gamma * ____ * (1-done))

td_error = td_target - value

# Calculate the actor loss

actor_loss = -____ * ____.detach()

# Calculate the critic loss

critic_loss = ____

return actor_loss, critic_loss

actor_loss, critic_loss = calculate_losses(

critic_network, action_log_prob,

reward, state, next_state, done

)

print(round(actor_loss.item(), 2), round(critic_loss.item(), 2))