Réduction de bruit audio

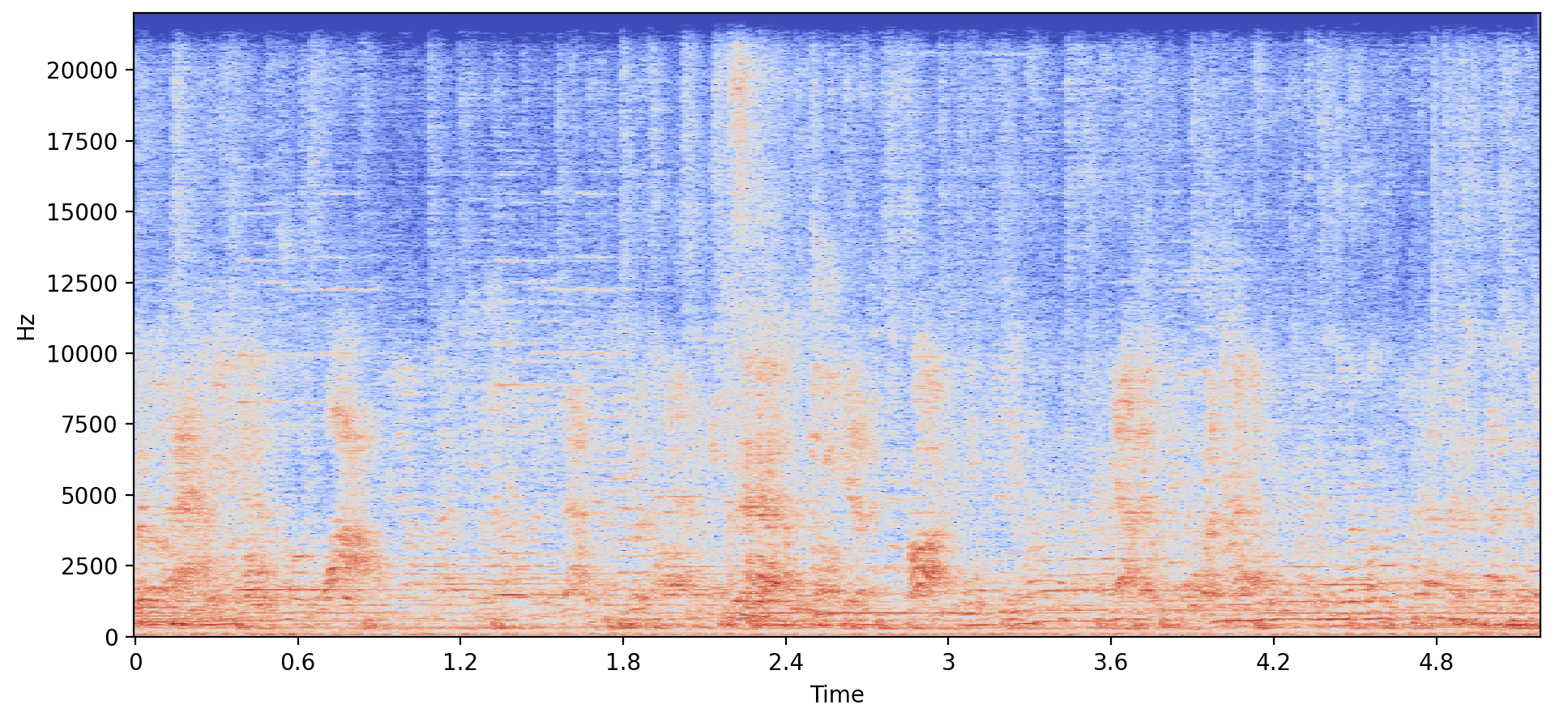

Dans cet exercice, vous allez utiliser des données du jeu de données WHAM, qui mélange la parole avec du bruit de fond, pour générer une nouvelle parole dans une voix différente et sans le bruit de fond !

Le tableau example_speech et le vecteur speaker_embedding de la nouvelle voix ont déjà été chargés. Le préprocesseur (processor) et le vocoder (vocoder) sont également disponibles, ainsi que le module SpeechT5ForSpeechToSpeech. Une fonction make_spectrogram() vous est fournie pour faciliter l’affichage des graphiques.

Cet exercice fait partie du cours

Modèles multimodaux avec Hugging Face

Instructions

- Chargez le modèle préentraîné

SpeechT5ForSpeechToSpeechavec le checkpointmicrosoft/speecht5_vc. - Prétraitez

example_speechavec une fréquence d’échantillonnage de16000. - Générez la parole débruitée à l’aide de

.generate_speech().

Exercice interactif pratique

Essayez cet exercice en complétant cet exemple de code.

# Load the SpeechT5ForSpeechToSpeech pretrained model

model = ____

# Preprocess the example speech

inputs = ____(audio=____, sampling_rate=____, return_tensors="pt")

# Generate the denoised speech

speech = ____

make_spectrogram(speech)

sf.write("speech.wav", speech.numpy(), samplerate=16000)