Apprentissage zero-shot avec CLIP

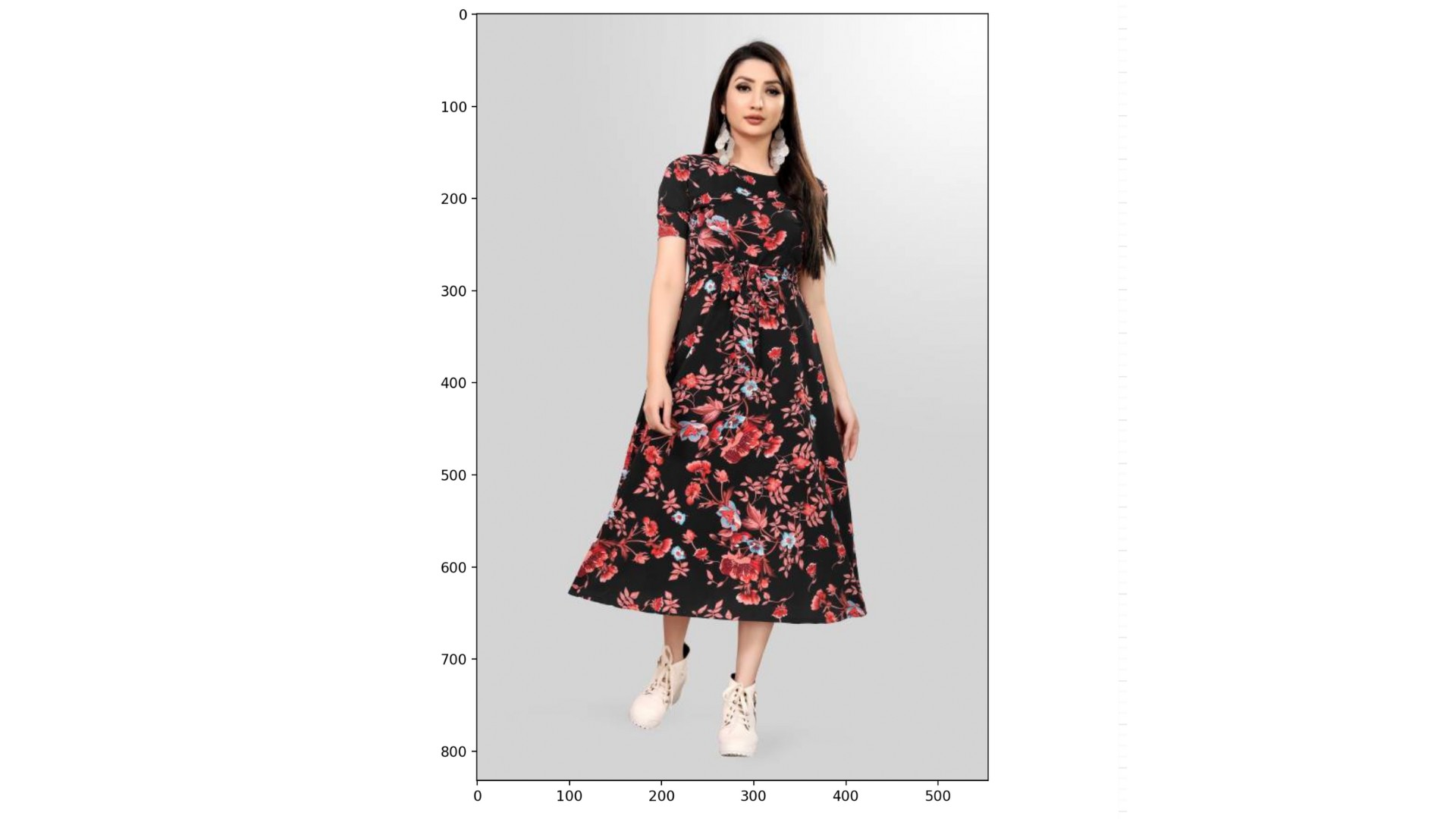

Vous allez utiliser le zero-shot learning pour classer une image du jeu de données rajuptvs/ecommerce_products_clip, qui contient environ 2 000 images de produits avec leurs descriptions associées :

Le jeu de données (dataset), le CLIPProcessor (processor) et le CLIPModel (model) ont été chargés pour vous, ainsi qu’une liste de catégories :

categories = ["shirt", "trousers", "shoes", "dress", "hat",

"bag", "watch", "glasses", "jacket", "belt"]

Cet exercice fait partie du cours

Modèles multimodaux avec Hugging Face

Instructions

- Utilisez le

processorpour prétraiter lescategorieset l’image à l’indice999dedataset; activez le padding. - Passez les

inputsdécompactés aumodel. - Calculez les probabilités de chaque catégorie en utilisant l’attribut

.logits_per_imageet la méthode.softmax(). - Trouvez la catégorie la plus probable à l’aide de

probsetcategories.

Exercice interactif pratique

Essayez cet exercice en complétant cet exemple de code.

# Preprocess the categories and image

inputs = ____(text=____, images=____, return_tensors="pt", padding=____)

# Process the unpacked inputs with the model

outputs = ____

# Calculate the probabilities of each category

probs = outputs.____.____(dim=1)

# Find the most likely category

category = categories[probs.____.item()]

print(f"Predicted category: {category}")