Audio-Rauschunterdrückung

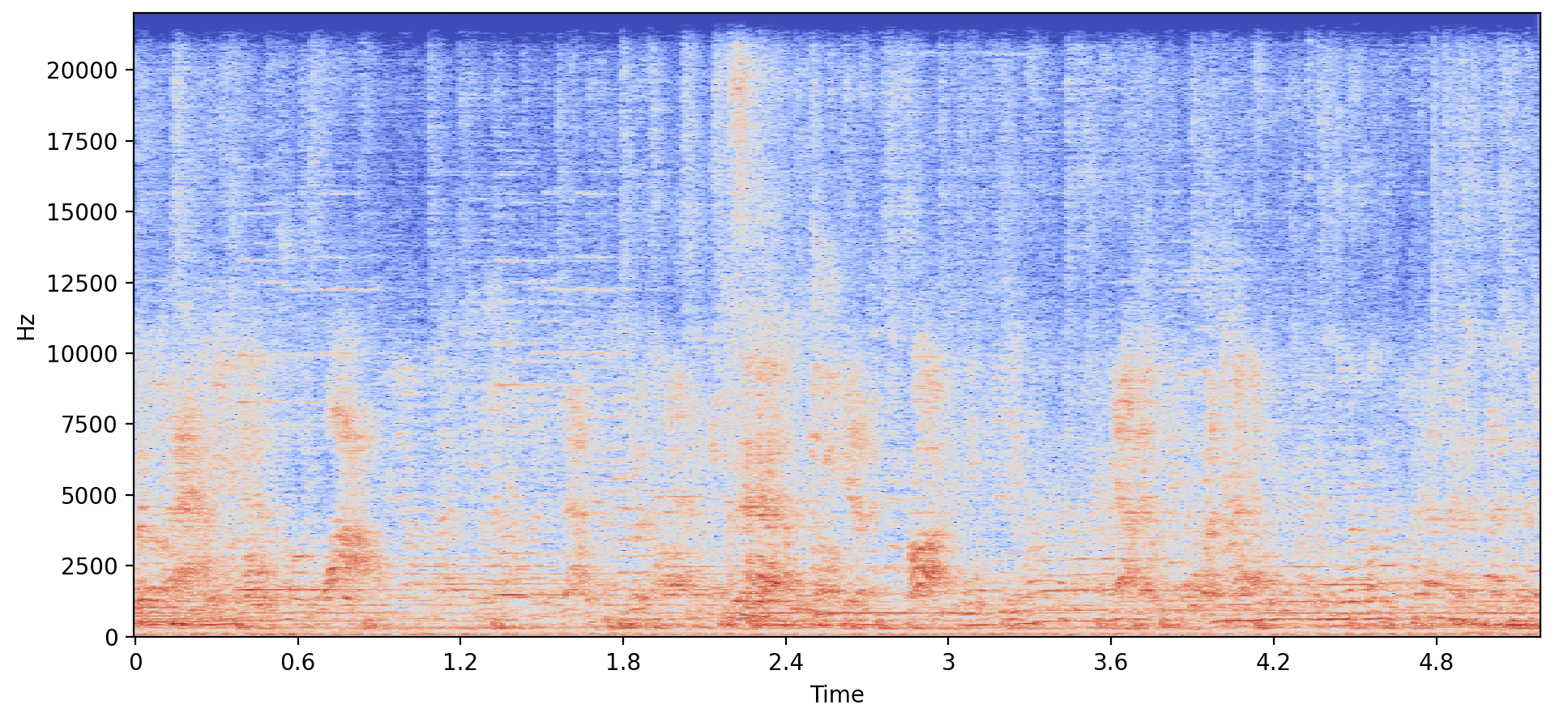

In dieser Übung wirst du Daten aus dem WHAM -Datensatz verwenden, der Sprache mit Hintergrundgeräuschen mischt, um neue Sprache mit einer anderen Stimme und ohne Hintergrundgeräusche zu erzeugen!

Das Array „ example_speech “ und der Vektor „ speaker_embedding “ der neuen Stimme wurden schon geladen. Der Preprozessor (processor) und der Vocoder (vocoder) sind auch verfügbar, zusammen mit dem Modul „ SpeechT5ForSpeechToSpeech “. Zum Erleichtern des Plottens wurde die Funktion „ make_spectrogram() “ bereitgestellt.

Diese Übung ist Teil des Kurses

Multimodale Modelle mit Hugging Face

Anleitung zur Übung

- Lade das vortrainierte Modell „

SpeechT5ForSpeechToSpeech” mit dem Checkpoint „microsoft/speecht5_vc” rein. example_speechmit einer Abtastrate von16000vorverarbeiten.- Erzeuge die rauscheredierte Sprache mit dem Befehl „

.generate_speech()“.

Interaktive Übung

Vervollständige den Beispielcode, um diese Übung erfolgreich abzuschließen.

# Load the SpeechT5ForSpeechToSpeech pretrained model

model = ____

# Preprocess the example speech

inputs = ____(audio=____, sampling_rate=____, return_tensors="pt")

# Generate the denoised speech

speech = ____

make_spectrogram(speech)

sf.write("speech.wav", speech.numpy(), samplerate=16000)