Schritte der Datenpipeline

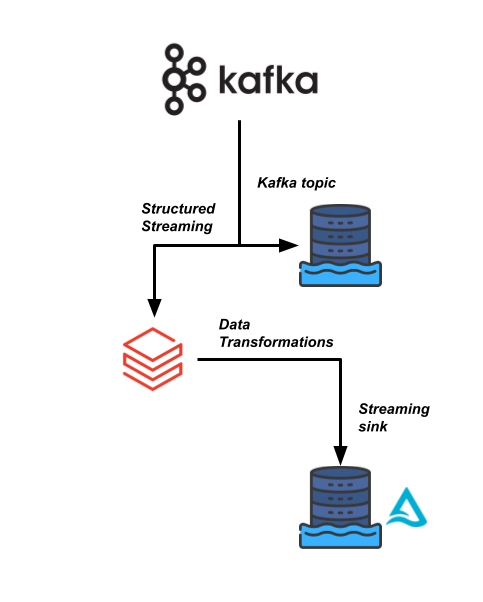

Eine deiner geschäftskritischeren Datenpipelines bei Sierra Publishing basiert auf einem hochfrequenten Datenstrom, der aus einem Kafka-Datenstream kommt. Wir müssen die Daten einlesen und mit ein paar anderen Datensätzen verknüpfen.

Dein Data-Engineering-Team möchte Databricks nutzen, um diese Datenpipeline effizienter zu machen und es nachgelagerten Nutzer:innen zu ermöglichen, die Daten in Echtzeit für ihre Analysen zu lesen.

Diese Übung ist Teil des Kurses

Databricks-Konzepte

Interaktive Übung

In dieser interaktiven Übung kannst du die Theorie in die Praxis umsetzen.

Übung starten

Übung starten